دیپ فیک چیست

اولین سوالی که مطرح میشود این است که تکنولوژی دیپ فیک چیست؟ دیپ فیک (Deepfake) به ویدیوها، تصاویر یا فایلهای صوتی دستکاریشدهای اطلاق میشود که با استفاده از الگوریتمهای پیشرفته هوش مصنوعی و یادگیری عمیق ساخته شدهاند. این فناوری بهگونهای طراحی شده که میتواند محتوای بصری و صوتی را با دقت و واقعگرایی بالایی شبیهسازی کند. عبارت دیپ فیک ترکیبی از دو کلمه “دیپ لرنینگ” (یادگیری عمیق) و “فیک” (جعلی) است که به خوبی ماهیت این فناوری را توصیف میکند.

دیپ فیکها طیف گستردهای از دستکاریهای رسانهای را شامل میشوند، از جمله:

- جایگزینی چهره یک فرد با چهره فرد دیگر در ویدیو

- تغییر حالات چهره و همگامسازی حرکات لب با صدا

- شبیهسازی صدای افراد

- تولید تصاویر و چهرههای کاملاً جدید که در واقعیت وجود ندارند

امروزه پیشرفتهای چشمگیر در زمینه هوش مصنوعی و دسترسی به حجم عظیمی از دادهها، امکان تولید دیپ فیکهایی با کیفیت بسیار بالا را فراهم کرده است، بهطوری که تشخیص واقعی از غیرواقعی برای انسان و حتی سیستمهای هوشمند بسیار دشوار شده است. این دقت و واقعگرایی، دیپ فیک را به ابزاری قدرتمند برای اهداف سرگرمی، خلاقیت و حتی کلاهبرداری تبدیل کرده است که نگرانیهای جدی در مورد سوءاستفاده از این فناوری را افزایش داده است.

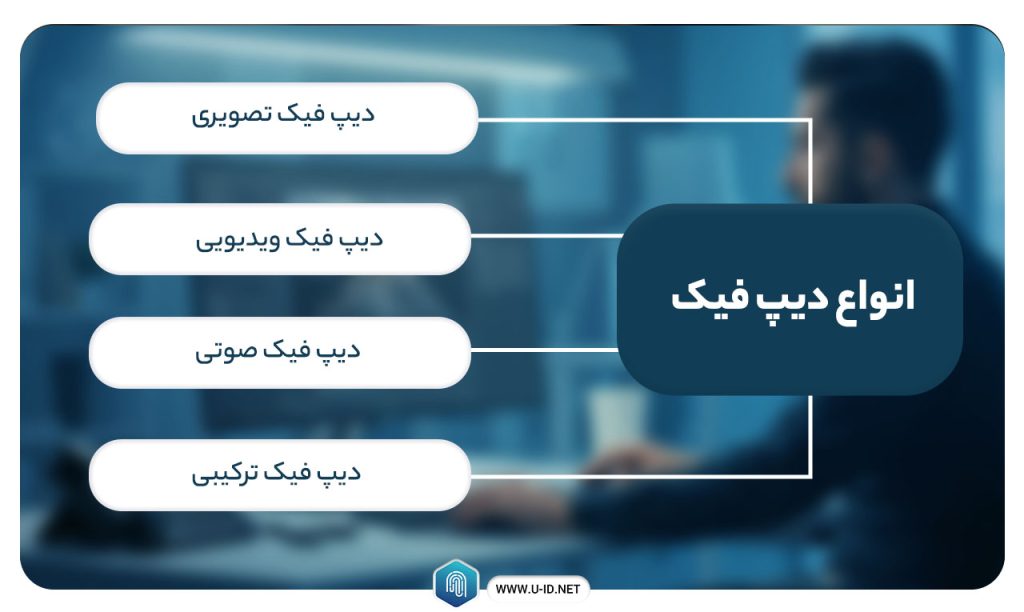

انواع دیپ فیک

دیپ فیکها در قالبهای مختلفی تولید میشوند که هر کدام کاربردها و چالشهای خاص خود را دارند:

دیپ فیک تصویری: دستکاری و ترکیب تصاویر با استفاده از هوش مصنوعی برای ایجاد تصاویر واقعگرایانه که در واقعیت وجود ندارند یا تغییر چهره افراد در عکسها.

دیپ فیک ویدیویی: یکی از رایجترین انواع دیپ فیک که در آن چهره یک فرد بهطور واقعگرایانه روی چهره فرد دیگری در ویدیو قرار میگیرد و حرکات چهره، پلک زدن و حالات با دقت بالا شبیهسازی میشود.

دیپ فیک صوتی: شبیهسازی صدای یک فرد با تحلیل نمونههای صوتی موجود از آن شخص. این فناوری میتواند صدای افراد را برای گفتن جملاتی که هرگز نگفتهاند، شبیهسازی کند.

دیپ فیک ترکیبی: ترکیبی از فناوریهای فوق برای ایجاد محتوای چندرسانهای کاملاً واقعگرایانه که هم تصویر و هم صدا را شبیهسازی میکند.

دیپ فیک چگونه کار میکند؟

فناوری دیپ فیک از ترکیب پیچیدهای از الگوریتمهای هوش مصنوعی و یادگیری عمیق استفاده میکند. فناوری دیپ فیک از ترکیب پیچیدهای از الگوریتمهای هوش مصنوعی و یادگیری عمیق استفاده میکند. در قلب این سیستمها، مفهومی انقلابی به نام «شبکههای مولد تخاصمی» (Generative Adversarial Networks | GANs) قرار دارد که در سال ۲۰۱۴ توسط یان گودفلو (Ian Goodfellow) و همکارانش ابداع شد.

در ادامه، به بررسی دقیقتر شبکههای مولد تخاصمی میپردازیم تا کارکرد دیپ فیک را بهراحتی درک کنیم.

شبکههای مولد تخاصمی (GAN)

همانطور که گفتیم در قلب فناوری دیپ فیک، شبکههای مولد تخاصمی یا GANs قرار دارند. این سیستم از دو شبکه عصبی مصنوعی تشکیل شده که در تقابل با یکدیگر کار میکنند:

شبکه مولد (Generator Network): این شبکه با استفاده از نمونههای تصویری، صوتی و یا ویدیویی آموزش میبیند تا محتوای جدیدی تولید یا محتوای موجود را دستکاری کند که تا حد امکان شبیه به نمونههای اصلی باشد.

شبکه تشخیصدهنده (Discriminator Network): وظیفه این شبکه تشخیص تفاوتها و ناهماهنگیها بین محتوای اصلی و محتوای تولیدشده توسط مولد است. این شبکه به مولد بازخورد میدهد تا بتواند خروجی خود را بهبود بخشد.

فرآیند کار به این صورت است:

- الگوریتمهای مولد و تشخیصدهنده دادههای موجود در نمونههای رسانهای را تحلیل میکنند.

- مولد، محتوایی جدید تولید میکند که تا حد امکان شبیه به نمونههای واقعی باشد. این نسخه اولیه دیپ فیک است.

- تشخیصدهنده، ناهماهنگیها بین نمونههای اصلی و دیپ فیک را بررسی میکند.

- مولد، ناهماهنگیهای پیداشده توسط تشخیصدهنده را اصلاح کرده و محتوا را مجدداً به تشخیصدهنده ارائه میدهد.

- این چرخه تکرار میشود تا زمانی که تشخیصدهنده نتواند ناهماهنگیهای بیشتری پیدا کند.

این فرآیند رقابتی باعث میشود که مولد به تدریج توانایی تولید محتوایی را به دست آورد که نه هوش مصنوعی و نه انسان نتوانند به راحتی تشخیص دهند که جعلی است. به بیان دیگر، این دو جزء در یک بازی مداوم شبیه به «دزد و پلیس» قرار میگیرند؛ مولد تلاش میکند محتوایی بسازد که تشخیصدهنده را فریب دهد، و تشخیصدهنده همزمان سعی میکند اشتباهات مولد را شناسایی کند. این رقابت تا جایی ادامه مییابد که خروجیهای مولد بهحدی واقعگرایانه شوند که حتی برای انسانها نیز تشخیص واقعی بودن آنها دشوار شود.

نقش شبکههای عصبی در تولید دیپ فیک

شبکههای عصبی مصنوعی، اساس فناوری دیپ فیک هستند. این شبکهها با ساختار “پیشخور” (feed-forward) متشکل از گرههای بههمپیوسته کار میکنند که مشابه نورونهای مغز انسان عمل میکنند. همانند مغز انسان، یک کامپیوتر میتواند از طریق آموزش، انجام یک وظیفه را یاد بگیرد.

در سال ۲۰۱۶، محققان MIT گزارش کردند که مدل محاسباتی آنها از مکانیسم تشخیص چهره مغز انسان، بازتولید خودبهخودی “بازنماییهای ثابت” چهرهها را ایجاد کرده است. آنها یک طرح یادگیری ماشین برای این مدل طراحی و آموزش دادند و دریافتند که “سیستم آموزشدیده شامل یک مرحله پردازش میانی بود که درجه چرخش چهره را نمایش میداد – مثلاً ۴۵ درجه از مرکز – اما جهت آن را نشان نمیداد – چپ یا راست”.

دادههای مورد نیاز برای تولید دیپ فیک

تولید دیپ فیکهای باکیفیت نیازمند حجم زیادی از دادهها، از جمله تصاویر، ویدیوها و فایلهای صوتی است. این مجموعه دادهها برای آموزش GANها (یا سایر مدلها) و بهبود توانایی آنها در تولید محتوای واقعگرایانه استفاده میشوند.

در عمل، برای تولید یک دیپ فیک با کیفیت بالا، به ویژه برای تعویض چهره در ویدیوها، صدها و گاهی هزاران تصویر از فرد مورد نظر در زوایا و حالات مختلف چهره نیاز است. هرچه تعداد و تنوع این دادهها بیشتر باشد، دیپ فیک نهایی واقعگرایانهتر خواهد بود.

فرآیند تولید یک ویدیو دیپ فیک به زبان ساده

مراحل اصلی تولید یک ویدیو دیپ فیک را میتوان به صورت زیر خلاصه کرد:

۱. جمعآوری دادهها: گردآوری تصاویر و ویدیوهای فرد مبدأ (که چهرهاش قرار است در ویدیو ظاهر شود) و فرد مقصد (که چهرهاش قرار است جایگزین شود).

۲. استخراج و آنالیز چهرهها: نرمافزار بهطور خودکار چهرهها را در تمامی فریمهای ویدیو شناسایی کرده و نقاط کلیدی چهره را استخراج میکند.

۳. آموزش مدل: الگوریتمهای یادگیری عمیق با استفاده از دادههای جمعآوری شده آموزش میبینند تا بتوانند چهره فرد مبدأ را با حفظ حالات و حرکات چهره فرد مقصد بازسازی کنند.

۴. تولید و ترکیب: مدل آموزشدیده، چهره جدید را برای هر فریم از ویدیوی مقصد تولید و سپس آن را بهطور یکپارچه با بقیه تصویر ترکیب میکند.

۵. پردازش نهایی: پسپردازشهایی مانند تطابق رنگ، بهبود کنتراست و افزودن جزئیات واقعگرایانه مانند سایهها انجام میشود تا نتیجه نهایی طبیعیتر به نظر برسد.

تاریخچه دیپ فیک

تاریخچه دیپ فیک به دهه ۱۹۹۰ و تلاشهای اولیه در مؤسسات آموزشی بازمیگردد، اما شکل امروزی آن با ظهور الگوریتمهای یادگیری عمیق و بهویژه شبکههای مولد تخاصمی (GAN) در سال ۲۰۱۴ توسعه یافت. نخستین نمونههای شناختهشده دیپ فیک در سال ۲۰۱۷ توسط کاربران اینترنت منتشر شد و از آن زمان تاکنون این فناوری به سرعت رشد کرده و کاربردهای متنوعی یافته است. در ادامه، به تاریخچه کامل این فناوری میپردازیم.

نخستین نمونهها و پیدایش

مفهوم دیپ فیک (یا دیپ فیکینگ) ریشه در تلاشهایی دارد که از دهه ۱۹۹۰ آغاز شد؛ در آن زمان، پژوهشگران با استفاده از فناوری CGI (تصاویر تولیدشده توسط کامپیوتر که شامل خلق تصاویر و جلوههای ویژه دیجیتال سهبعدی و دوبعدی در فیلمها و بازیها است) تلاش میکردند تا تصاویر واقعگرایانهای از انسانها و محیطهای مختلف بسازند. اما این فناوری در دهه ۲۰۱۰ با در دسترس قرار گرفتن مجموعه دادههای بزرگ، پیشرفتهای یادگیری ماشین و قدرت منابع محاسباتی جدید مورد توجه بیشتری قرار گرفت.

نقطه عطف واقعی برای دیپ فیکها به پیشرفت انقلابی در یادگیری عمیق در سال ۲۰۱۴ توسط ایان گودفلو (Ian Goodfellow) و تیم او نسبت داده میشود. گودفلو مفهومی در یادگیری ماشین به نام شبکه مولد تخاصمی (GAN) را معرفی کرد که در نهایت نسل بعدی دیپ فیکهای بسیار پیچیده تصویری، ویدیویی و صوتی را امکانپذیر ساخت.

نامگذاری و گسترش عمومی

اصطلاح “دیپ فیک” در سال ۲۰۱۷ توسط یکی از مدیران Reddit با همین نام مستعار ابداع شد که یک زیرمجموعه در Reddit برای تبادل تصاویر پورنوگرافی دیپ فیک ایجاد کرده بود که با استفاده از تصاویر افراد مشهور و فناوری تعویض چهره منبعباز تولید شده بودند. اگرچه این انجمن نامناسب از آن زمان حذف شده است، اما واژه دیپ فیک به عنوان برچسب جدیدی برای نوعی از رسانههای تولیدشده با هوش مصنوعی ماندگار شده است.

رشد و تحول در سالهای اخیر

در تاریخچه دیپ فیکها نمیتوان نقش کاربران معمولی اینترنت را نادیده گرفت. ابزارهای منبعباز تولید دیپ فیک توسط انبوهی از علاقهمندان آماتور آزمایش و اصلاح شدهاند که از این ابزارها برای اهداف سرگرمی بیضرر (مانند میمها، جایگزینی چهره بازیگران در فیلمهای کلاسیک) و اهداف شومتر و نگرانکنندهتر، مانند تولید پورنوگرافی با دیپ فیک استفاده کردهاند. این مشارکت و علاقه روزافزون کاربران عادی از سال ۲۰۱۷، فناوری را به جایگاه کنونی آن رسانده است.

دموکراتیزه شدن مداوم چنین ابزارهای قدرتمندی نشاندهنده نیاز فوری به اقدامات متقابل مناسب برای شناسایی و جداسازی دیپ فیکها قبل از استفاده آنها برای اهداف مخرب است. فناوری دیپ فیک از سال ۲۰۱۸ تاکنون رشد چشمگیری داشته و هر روز پیشرفتهتر و در دسترستر میشود.

نمونههایی از ویدیوهای دیپ فیک

نمونههای ویدیوهای دیپ فیک، نشاندهنده توانمندی شگفتانگیز این فناوری در تولید تصاویر و ویدیوهای بسیار واقعگرایانه و گاه فریبنده هستند. از ساخت ویدیوهای سرگرمکننده با چهره افراد مشهور گرفته تا کاربردهای جدیتر در سیاست و امنیت، دیپ فیکها دامنه گستردهای از استفادهها را شامل میشوند که هم فرصتها و هم چالشهای بزرگی را به همراه دارند. در ادامه، به بررسی چند نمونه از ویدیوها با دیپ فیک میپردازیم.

ویدیوهای دیپ فیک سرگرمی و خلاقانه

یکی از معروفترین نمونههای دیپ فیک در زمینه سرگرمی، ویدیوهای تام کروز در تیکتاک است که توسط یک هنرمند افکتهای ویژه ساخته شده و در آن چهره تام کروز بهطور باورنکردنی واقعی روی بدن یک بدل قرار گرفته است. این ویدیوها به سرعت وایرال شدند و توجه جهانی را به قدرت فناوری دیپ فیک جلب کردند.

ویدیوهای دیپ فیک سیاسی و خطرناک

در سال ۲۰۲۲، یک شبکه تلویزیونی اوکراینی که هک شده بود، ویدیوی دیپ فیکی از ولودیمیر زلنسکی، رئیس جمهور اوکراین، پخش کرد که در آن به سربازان اوکراینی دستور میداد سلاحهای خود را زمین بگذارند و تسلیم نیروهای روسی شوند. اگرچه این ویدیو به وضوح جعلی بود و حرکات غیرطبیعی صورت و مشکلات همگامسازی لب داشت، اما قبل از اینکه حقیقتسنجها بتوانند جلوی آسیب را بگیرند، به سرعت در رسانههای اجتماعی پخش شد.

همچنین در سال ۲۰۱۹، ویدیوی دستکاریشدهای از نانسی پلوسی، رئیس مجلس نمایندگان آمریکا، در صفحهای از فیسبوک منتشر شد. در این ویدیو سرعت سخنرانی او به عمد کاهش داده شده بود تا به مخاطب القا شود که او در حال مست بودن یا داشتن مشکل تکلم است. این ویدیو با بیش از سه میلیون بازدید، گمانهزنیهایی درباره وضعیت سلامت و رفتار او به وجود آورد و توسط مخالفان سیاسی بهویژه جمهوریخواهان به عنوان سندی برای اثبات اعتیاد یا ناتوانی او مورد استفاده قرار گرفت. هرچند این ویدیو جعلی بود و دستکاری شده بود، اما فیسبوک در ابتدا از حذف آن خودداری کرد و اجازه داد ویدیو به سرعت منتشر شود. پس از مدتی و تحت فشارهای عمومی، این ویدیو حذف شد اما مشخص نشد که چه کسی آن را ساخته است. این اتفاق نشان داد که چگونه میتوان با تغییر سرعت ویدیو و دستکاریهای ساده، محتوایی را به شکلی فریبنده تغییر داد و تاثیرات سیاسی و اجتماعی گستردهای ایجاد کرد.

در ادامه، چند هفته پس از این ماجرا، ویدیوی دیپ فیک پیشرفتهتری از مارک زاکربرگ در اینستاگرام منتشر شد که در آن او ظاهراً درباره کنترل اطلاعات کاربران صحبت میکرد. این ویدیو که با فناوری پیشرفتهای ساخته شده بود، نشان داد که دیپ فیکها چگونه میتوانند برای اهداف سیاسی و رسانهای پیچیدهتر مورد استفاده قرار گیرند و چالشهای جدیدی برای تشخیص و مقابله ایجاد کنند.

ویدیوهای دیپ فیک کلاهبرداری مالی و استخدامی

در سال ۲۰۲۰، مجرمان سایبری با استفاده از فناوری صدای تولیدشده با هوش مصنوعی، صدای مدیرعامل یک شرکت را جعل کردند و به یک مدیر بانک دستور دادند ۳۵ میلیون دلار به حسابهای کلاهبرداری منتقل کند. مدیر بانک که متقاعد شده بود صدا واقعی است، این تراکنش را تأیید کرد.

در تابستان سال جاری، شرکت امنیت سایبری KnowBe4 به اشتباه یک هکر کره شمالی را به عنوان کارمند بخش فناوری اطلاعات از راه دور استخدام کرد. این فرد با جعل هویت با استفاده از دیپ فیک و ارائه مدارک جعلی، از بررسی پیشینه، ارزیابیها و چهار مصاحبه ویدیویی عبور کرد و توانست اعتماد شرکت را جلب کند. پس از استخدام، او به سرعت شروع به بارگذاری بدافزارهای مخرب کرد و به شبکه داخلی شرکت نفوذ کرد. این هکر به مدت چند ماه به طور پنهانی به دادهها و اطلاعات حساس شرکت دسترسی داشت و آنها را دانلود کرد. پس از اخراج، با ارسال ایمیلهای باجخواهی و تهدید به انتشار اطلاعات سرقتشده، درخواست پرداخت باج به ارز دیجیتال کرد. این حادثه نمونهای از خطرات فزاینده کلاهبرداری استخدامی با استفاده از هویتهای دیپ فیک و جعل هویت در فرآیندهای استخدام از راه دور است و هشدار جدی به شرکتها برای افزایش دقت در بررسی هویت و سوابق کارکنان دورکار محسوب میشود.

این نمونهها نشان میدهند که دیپ فیکها میتوانند در طیف گستردهای از زمینهها از سرگرمی گرفته تا کلاهبرداری و دستکاری سیاسی مورد استفاده قرار گیرند؛ این موضوع اهمیت آگاهی عمومی و راهکارهای تشخیص آنها را برجسته میکنند.

مزایا و معایب دیپ فیک

فناوری دیپ فیک مانند یک تیغ دولبه است؛ از یک سو میتواند باعث تحول در حوزههایی مانند سرگرمی، آموزش و بازاریابی شود و هزینهها را کاهش دهد، اما از سوی دیگر به دلیل امکان جعل واقعگرایانه تصاویر و ویدیوها، تهدیدهایی جدی برای اعتماد عمومی، امنیت و آبروی افراد ایجاد میکند. در ادامه به طور جداگانه به مزایا و معایب این فناوری میپردازیم.

مزایای دیپ فیک

۱. صنعت سرگرمی و تولید فیلم و بازی:

فناوری دیپ فیک صنعت سرگرمی را متحول کرده است و به فیلمسازان این امکان را میدهد با ترکیب یکپارچه بازیگران با عناصر دیجیتال، صحنهها و شخصیتهای بصری خیرهکنندهای خلق کنند. همچنین سناریوهای تخیلی که قبلاً غیرممکن بودند، مانند بازگرداندن بازیگران فوت شده به صفحه نمایش را امکانپذیر میکند. علاوه بر این، راههای جدیدی برای جلوههای ویژه و تصاویر تولیدشده با کامپیوتر (CGI) فراهم میکند.

میتوان پیشبینی کرد که فناوری دیپ فیک، تجربه سینمایی را با گسترش مرزهای داستانسرایی و افزایش مشارکت مخاطب به سطح کاملاً جدیدی ارتقا دهد. در صنعت بازیهای ویدیویی نیز، این فناوری میتواند به ایجاد شخصیتهای واقعیتر، محیطهای پویاتر و تجربیات غوطهورتر کمک کند.

۲. کاربردهای آموزشی و تاریخی:

فناوری دیپ فیک میتواند در محیطهای آموزشی بهطور مؤثری استفاده شود، مثلاً برای بازآفرینی رویدادهای تاریخی یا سخنرانیهای معروف. به این ترتیب، دانشآموزان میتوانند لحظات مهم تاریخ را از نزدیک مشاهده کنند و درک عمیقتر و فرصت تعامل بیشتری با موضوع به دست آورند. علاوه بر این، دیپ فیک میتواند به محققان در تحلیل و بازسازی آثار باستانشناسی و ترمیم تصاویر تاریخی آسیبدیده کمک کند.

۳. آموزش شبیه سازی شده:

فناوری دیپ فیک میتواند برای اهداف آموزشی در زمینههای مختلف مانند بهداشت، نظامی و اجرای قانون استفاده شود. سناریوهای شبیهسازیشده میتوانند آموزشهای نجاتبخش را با فراهم کردن محیطی امن و کنترلشده برای متخصصان جهت توسعه مهارتهای عملی در تصمیمگیری بحرانی، مدیریت بحران و حل تعارض امکانپذیر و آسانتر کنند.

معایب و خطرات دیپ فیک

۱. انتشار اطلاعات نادرست و دستکاریشده:

یکی از بزرگترین نگرانیهای ایجادشده توسط فناوری دیپ فیک، امکان انتشار اطلاعات نادرست و دستکاری افکار عمومی است. توانایی دستکاری و جعل محتوای رسانهای با چنین دقت و واقعگرایی، تهدیداتی از جمله گسترش اطلاعات نادرست، تخریب شخصیت و کلاهبرداری را به همراه دارد.

۲. جعل هویت و سوءاستفاده:

دیپ فیکها امکان جعل هویت افراد را به شکل بسیار پیشرفته فراهم میکنند. این موضوع میتواند منجر به سوءاستفادههای متعددی شود، از جمله:

- جعل هویت در تماسهای ویدیویی

- ارائه شهادتها و بیانیهها یا اظهارات جعلی از افراد مشهور

- ایجاد مدارک جعلی برای اهداف کلاهبرداری

۳. تأثیر منفی بر اعتماد عمومی:

با افزایش کیفیت و گسترش دیپ فیکها، تمایز بین واقعیت و فریب برای عموم مردم دشوارتر میشود. این امر میتواند منجر به کاهش اعتماد عمومی به رسانهها، خبرگزاریها و حتی شواهد تصویری و صوتی در دادگاهها شود. در عصری که “با چشم دیدن برای باور کردن” دیگر صادق نیست، چالشهای جدی برای جوامع دموکراتیک و سیستمهای قضایی ایجاد میشود.

خطرات دیپ فیک چیست؟

از مهمترین خطراتی که دیپ فیک میتواند برای افراد ایجاد کند، میتوان به موارد زیر اشاره کرد:

تهدیدهای امنیتی:

دیپ فیکها تهدیدهای امنیتی متعددی را ایجاد میکنند که میتوانند به افراد، سازمانها و حتی امنیت ملی کشورها آسیب برسانند. برخی از مهمترین این تهدیدها عبارتند از:

۱. کلاهبرداری مالی: کلاهبرداران با استفاده از فناوری شبیهسازی صدا میتوانند خود را بهعنوان مدیران ارشد شرکتها جا بزنند و کارمندان را فریب دهند تا انتقال پول انجام دهند.

۲. دستکاری سیاسی و انتخاباتی: دیپ فیکها میتوانند برای ایجاد رسواییهای ساختگی، انتشار اظهارات جعلی از سیاستمداران یا ایجاد موجهای اطلاعات نادرست در آستانه انتخابات استفاده شوند. کارشناسان هشدار میدهند که دیپ فیکهای سیاسی تولیدشده با هوش مصنوعی میتوانند به ابزار مهمی برای دخالت در انتخابات تبدیل شوند که تشخیص حقیقت از دروغ را برای رأیدهندگان دشوار میکند.

آسیب به اعتماد اجتماعی:

یکی از پیامدهای گستردهتر دیپ فیکها، تأثیر منفی آنها بر اعتماد اجتماعی است. در جامعهای که در آن هر ویدیو یا تصویر میتواند جعلی باشد، مردم ممکن است به تدریج به همه چیز با دیده تردید نگاه کنند. این امر میتواند منجر به پدیده “واقعیتگریزی” (reality apathy) شود، جایی که افراد به دلیل ناتوانی در تشخیص واقعیت از جعل، بهطور کلی از پذیرش هرگونه شواهد تصویری یا صوتی خودداری میکنند.

این کاهش اعتماد میتواند تأثیرات منفی عمیقی بر نهادهای دموکراتیک، رسانههای خبری و حتی روابط بینفردی داشته باشد. در محیطی که “حقیقت” مفهومی نسبی تلقی شود، پایههای گفتوگوی سازنده و تصمیمگیری آگاهانه تضعیف میشود.

تأثیر بر حریم خصوصی و آبرو:

دیپ فیکها میتوانند بهطور مستقیم حریم خصوصی افراد را نقض کنند و به آبرو و اعتبار افراد آسیب برسانند. موارد زیر نمونههایی از این آسیبها هستند:

آسیب به شهرت و اعتبار: دیپ فیکها میتوانند برای تخریب شهرت افراد از طریق نمایش آنها در موقعیتهای ناخوشایند، بیان سخنانی که هرگز نگفتهاند، یا انجام اعمالی که هرگز انجام ندادهاند، استفاده شوند. چنین آسیبهایی به شهرت ممکن است حتی پس از مشخص شدن جعلی بودن محتوا نیز ماندگار باشند.

اخاذی و باجگیری: مجرمان میتوانند از تهدید به انتشار محتوای دیپ فیک برای اخاذی و باجگیری استفاده کنند. این تهدید بهویژه زمانی مؤثر است که قربانیان نگران آسیب به شهرت یا زندگی شخصی خود باشند، حتی اگر بدانند محتوا جعلی است.

فناوری های مقابله با دیپ فیک

با افزایش تهدیدهای ناشی از دیپ فیک، تلاشهای گستردهای برای توسعه فناوریهای تشخیص و مقابله با آن در حال انجام است. این تلاشها شامل روشهای فنی پیشرفته و همچنین اقدامات آموزشی و افزایش آگاهی عمومی میشود.

روش های تشخیص دیپ فیک

پژوهشگران و متخصصان فناوری، روشهای مختلفی را برای تشخیص دیپ فیکها توسعه دادهاند، از جمله:

تشخیص مبتنی بر یادگیری عمیق:

پژوهشگران مدلهایی مبتنی بر یادگیری عمیق را توسعه دادهاند که میتوانند ناهنجاریها و نشانههای دستکاری در ویدیوها را تشخیص دهند. این مدلها با استفاده از مجموعه دادههای بزرگی از ویدیوهای اصلی و دستکاریشده آموزش میبینند تا الگوهای خاص دیپ فیکها را شناسایی کنند.

تشخیص مبتنی بر کاهش معنایی و آموزش بین دامنهای:

روشهای پیشرفتهتر مانند کاهش معنایی و آموزش بین دامنهای، قادر به تشخیص دیپ فیکها در ویدیوهای با کیفیت پایین و بینکیفیتی (تلفیق کیفیت بالا و پایین) هستند. این روشها از دو انگیزه پیروی میکنند:

- کاهش معنایی سطح بالا

- آموزش بین دامنهای

برای مورد اول، تخریب ساختار چهره و زیان پازل خصمانه پیشنهاد شده تا مدل به یادگیری معنایی سطح بالا کاهش یابد و بر یادگیری اطلاعات تشخیصی سطح پایین تمرکز کند. برای مورد دوم، روش تعمیم دامنه مبتنی بر یادگیری خصمانه پیشنهاد شده است.

روشهای مبتنی بر تبدیل موجک و مولد باقیمانده شرطی:

برخی پژوهشها از روشهای پیشرفتهتر مانند مولدهای باقیمانده شرطی و تبدیلات موجک برای فریب سیستمهای تشخیص دیپ فیک استفاده میکنند. این پژوهشها به ما کمک میکنند تا نقاط ضعف سیستمهای تشخیص کنونی را بهتر درک کنیم و آنها را بهبود بخشیم.

نقش شرکتهای بزرگ فناوری در مقابله با دیپ فیک

شرکتهای بزرگ فناوری در مقابله با خطر دیپ فیکها نقش مهمی دارند:

توسعه ابزارهای تشخیص: شرکتهایی مانند گوگل، فیسبوک، مایکروسافت و دیگر غولهای فناوری، سرمایهگذاریهای قابل توجهی در توسعه فناوریهای تشخیص دیپ فیک انجام دادهاند. این شرکتها چالشهای عمومی و رقابتهایی را برای تشویق پژوهشگران به توسعه الگوریتمهای بهتر تشخیص دیپ فیک برگزار میکنند.

سیاستهای مقابله با محتوای دیپ فیک: پلتفرمهای رسانههای اجتماعی در حال توسعه سیاستهایی برای مقابله با انتشار دیپ فیکهای مخرب هستند. این سیاستها شامل برچسبگذاری محتوای دستکاریشده، حذف دیپ فیکهای زیانبار و محدودسازی گسترش آنها میشود.

همکاری صنعتی: صنعت فناوری در حال همکاری برای ایجاد استانداردهای مشترک برای نشانهگذاری و تأیید اصالت محتوا است. این امر شامل توسعه فناوریهای اثبات منشأ است که میتواند منبع و تاریخچه یک محتوا را تأیید کند.

آموزش عمومی و سواد رسانهای برای مقابله با دیپ فیک

مقابله با تأثیرات منفی Deep Fake تنها با راهحلهای فناورانه امکانپذیر نیست. آموزش عمومی و افزایش سواد رسانهای نیز نقش حیاتی دارند. برای این کار باید به موارد زیر اهمیت بیشتری داد:

افزایش آگاهی عمومی: آگاهی بخشی به عموم مردم درباره وجود و ماهیت دیپ فیکها، اولین قدم در کاهش تأثیر منفی آنهاست. این امر شامل آموزش مردم درباره نشانههای احتمالی دیپ فیک، مانند حرکات غیرطبیعی چهره، عدم تطابق صدا و تصویر، یا مشکلات در همگامسازی لبها میشود.

افزایش سواد دیجیتال و رسانهای: توسعه مهارتهای سواد دیجیتال و رسانهای به افراد کمک میکند تا با نگاه انتقادی به محتوای آنلاین برخورد کنند. این امر شامل آموزش روشهای ارزیابی منابع، تحقیق درباره ادعاها و مشکوک بودن به محتوای بیمنبع یا غیرمعمول میشود.

ارائه راهنماهای عملی برای عموم مردم: ارائه راهنماهای عملی به عموم مردم درباره نحوه واکنش به دیپ فیکهای مشکوک، مانند گزارش به پلتفرمها، جستجوی منابع تأییدکننده و خودداری از انتشار محتوای تأییدنشده، میتواند به محدود کردن انتشار و تأثیر دیپ فیکهای مضر کمک کند.

آینده دیپ فیک

با پیشرفت سریع هوش مصنوعی، فناوری دیپ فیک نیز به سرعت در حال تکامل است و انتظار میرود کیفیت و واقعگرایی این ویدیوهای جعلی به مراتب بیشتر شود. این پیشرفتها باعث میشوند تشخیص دیپ فیک حتی برای متخصصان و الگوریتمهای پیشرفته نیز دشوارتر شود. همچنین، ابزارهای تولید دیپ فیک به مرور سادهتر، ارزانتر و در دسترستر شدهاند که این موضوع منجر به افزایش چشمگیر تعداد و تنوع دیپ فیکها در فضای مجازی خواهد شد. ترکیب دیپ فیک با فناوریهای نوظهوری مانند واقعیت مجازی و واقعیت افزوده نیز مرزهای بین دنیای واقعی و مجازی را بیش از پیش کمرنگ میکند و کاربردهای جدید و چالشهای تازهای را به همراه دارد.

با این حال، گسترش دیپ فیکها چالشهای قانونی و اخلاقی مهمی را نیز به دنبال دارد. تدوین قوانین مناسب که هم از سوءاستفاده جلوگیری کند و هم آزادی بیان را محدود نسازد، یکی از ضرورتهاست. همچنین تعیین مسئولیت پلتفرمهای آنلاین در قبال محتوای دیپ فیک و حفاظت از حقوق افراد بر تصویر و صدای خود از مسائل کلیدی آینده خواهد بود. در نهایت، جامعه باید تعادلی میان تشویق نوآوری و حفظ امنیت و اعتماد عمومی برقرار کند؛ پرسشی که پاسخ آن در سالهای آینده تعیینکننده سرنوشت فناوری دیپ فیک خواهد بود.

فناوری تشخیص چهره و مقابله آن با دیپ فیک

فناوری دیپ فیک نمونهای بارز از پیشرفتهای دوگانه در عرصه هوش مصنوعی است؛ ابزاری که میتواند هم فرصتهای نوآورانهای در حوزههایی مانند سرگرمی، آموزش و بازاریابی دیجیتال ایجاد کند و هم تهدیدهایی جدی برای امنیت، اعتماد عمومی و حریم خصوصی به همراه داشته باشد. با افزایش کیفیت و گستردگی دسترسی به ابزارهای دیپ فیک، اهمیت بهکارگیری راهکارهای پیشرفته برای مقابله با سوءاستفادههای احتمالی بیشتر از همیشه احساس میشود. در این میان، استفاده از فناوری تطبیق یا تشخیص چهره و راهکارهای احراز هویت دیجیتال مانند تشخیص زنده بودن تصویر نقش کلیدی در افزایش امنیت و اطمینان کاربران ایفا میکند. برای اطلاعات بیشتر، به صفحه تشخیص زنده بودن تصویر Liveness Detection سر بزنید.

پلتفرمهایی مانند یوآیدی با ارائه وب سرویس احراز هویت و فناوریهای بومی تشخیص چهره، به کسبوکارها و سازمانها کمک میکنند تا هویت کاربران خود را به صورت سریع، دقیق و ایمن تأیید و از جعل هویت و کلاهبرداری دیجیتال پیشگیری کنند.

برای دریافت وب سرویس های احراز هویت در کسبوکار خود، از طریق فرم با کارشناسان یوآیدی ارتباط بگیرید.

سوالات متداول

بله، با استفاده از ابزارهای هوش مصنوعی و روشهای تخصصی میتوان بسیاری از ویدیوهای دیپ فیک را شناسایی کرد، هرچند تشخیص نمونههای پیشرفته دشوارتر است.

خیر، دیپ فیک علاوه بر سوءاستفاده، کاربردهای مثبتی مانند تولید محتوا، آموزش و سرگرمی نیز دارد.

فتوشاپ برای ویرایش تصاویر ثابت به کار میرود، اما دیپ فیک با هوش مصنوعی و یادگیری عمیق، ویدیو و صدا را به صورت واقعگرایانه دستکاری میکند.

بله، امروزه ابزارهای تولید دیپ فیک به راحتی در دسترس عموم قرار گرفته و هر کسی میتواند از آنها استفاده کند.

با استفاده از فناوریهای تشخیص مبتنی بر هوش مصنوعی، بررسی دقیق و افزایش سواد رسانهای میتوان با دیپ فیک مقابله کرد.